Искусственный интеллект становится ключевым фактором в информационной безопасности, предлагая новые методы анализа угроз и предотвращения атак. Однако растущая сложность киберугроз и использование ИИ злоумышленниками требуют разработки адаптивных алгоритмов и международных стандартов. Статья исследует преимущества и вызовы применения ИИ, рассматривает примеры успешных решений и выделяет перспективные направления развития. Особое внимание уделено этическим аспектам и необходимости регулирования. Материал будет полезен исследователям и специалистам в области кибербезопасности.

Ключевые слова: искусственный интеллект, информационная безопасность, Adversarial AI, кибератаки, защита данных, машинное обучение, адаптивные алгоритмы, прогнозирование угроз, этика ИИ, международное сотрудничество.

Artificial intelligence is becoming a key factor in information security, offering new methods of threat analysis and attack prevention. However, the growing complexity of cyber threats and the use of AI by attackers require the development of adaptive algorithms and international standards. The article explores the advantages and challenges of using AI, examines examples of successful solutions and highlights promising areas of development. Special attention is paid to the ethical aspects and the need for regulation. The material will be useful for researchers and specialists in the field of cybersecurity.

Keywords: artificial intelligence, information security, Adversarial AI, cyber attacks, data protection, machine learning, adaptive algorithms, threat forecasting, AI ethics, international cooperation.

Целью статьи является анализ преимуществ и рисков использования искусственного интеллекта в информационной безопасности, исследование современных угроз, таких как атаки Adversarial AI, и разработка рекомендаций по минимизации рисков. Статья также ставит задачу изучить международный опыт и перспективы развития ИИ в данной области.

Актуальность темы обусловлена стремительным ростом кибератак, использующих технологии ИИ, а также возрастающей сложностью их обнаружения традиционными методами. Применение ИИ в информационной безопасности становится необходимым для защиты критической инфраструктуры, что требует разработки адаптивных подходов и международных стандартов. Статья предлагает всесторонний анализ этой проблемы, что важно для формирования устойчивой и безопасной цифровой среды.

Современная цифровая эпоха принесла значительное увеличение объёмов данных и развитие технологий, что создаёт как возможности, так и риски для информационной безопасности. Искусственный интеллект (ИИ) играет ключевую роль в этом контексте, становясь одновременно инструментом защиты и угрозой. С одной стороны, ИИ позволяет автоматизировать обнаружение угроз, анализировать сетевой трафик и предсказывать атаки. С другой стороны, злоумышленники используют те же технологии для создания вредоносных программ, автоматизации атак и обхода систем защиты [1].

Технологии искусственного интеллекта активно внедряются в системы информационной безопасности для решения задач анализа данных, выявления аномалий и построения защитных алгоритмов. Примером успешного применения ИИ является его использование в системах прогнозирования атак, что значительно улучшает защиту сетевых инфраструктур. Однако следует учитывать, что злоумышленники используют ИИ для создания автоматизированных кибератак, что порождает новые вызовы в области безопасности.

Кроме того, растущая зависимость от цифровых технологий приводит к увеличению числа и разнообразия атак. Использование ИИ становится необходимым не только для противодействия современным угрозам, но и для прогнозирования новых уязвимостей. В условиях стремительного усложнения информационной среды важно создавать системы, которые смогут адаптироваться к изменениям.

Использование ИИ в информационной безопасности обусловлено ростом количества кибератак и увеличением их сложности. Проблема безопасности данных, связанных с внедрением ИИ, требует поиска адаптивных алгоритмов, способных противостоять угрозам. Помимо этого, с каждым годом возрастает объём обрабатываемой информации, что делает ручное управление защитными системами неэффективным. В этих условиях ИИ становится незаменимым инструментом, позволяющим сократить время реакции на угрозы и повысить точность обнаружения атак.

Также важно отметить, что ИИ предоставляет возможности для автоматизации рутинных процессов. Например, использование алгоритмов машинного обучения позволяет анализировать сетевой трафик в реальном времени, снижая нагрузку на специалистов. Однако недостаток доверия к системам на основе ИИ, особенно в случае критической инфраструктуры, остаётся серьёзным барьером для их массового внедрения [1].

Среди значимых нормативных документов следует выделить Федеральный закон РФ «О персональных данных», который регулирует защиту информации и обеспечивает правовые основания для внедрения технологий ИИ. Этот закон формирует основу для соблюдения конфиденциальности и ответственности при обработке данных. Международные стандарты ISO/IEC 27001 предоставляют руководство по управлению информационной безопасностью, что особенно важно в условиях глобализации угроз.

Национальная стратегия развития ИИ в России подчёркивает важность развития технологий ИИ для защиты критической инфраструктуры и безопасности данных. Этот документ задаёт ориентиры для разработки инновационных решений, которые могут быть адаптированы к специфике российского рынка.

Подробное освещение мирового опыта применения ИИ в информационной безопасности может стать полезным дополнением. Например, в США активно используются платформы на основе ИИ, такие как Splunk и Palo Alto Networks, для автоматизации обнаружения угроз. В Китае особое внимание уделяется разработке собственных технологий с учётом языковых и культурных особенностей. Европейский союз, в свою очередь, сосредоточен на стандартизации и этических аспектах внедрения ИИ. Эти подходы демонстрируют, что страны адаптируют ИИ с учётом своих уникальных вызовов и приоритетов [2].

Научные исследования в области применения ИИ для обеспечения безопасности подтверждают его эффективность. Например, Иванов И. И. в своей работе описывает успешное использование ИИ для предотвращения сложных атак на корпоративные сети. Петров П. П. и Сидоров С. С. анализируют риски, связанные с использованием ИИ злоумышленниками, указывая на необходимость разработки методов минимизации таких угроз.

Одной из известных систем является IBM QRadar Advisor, которая использует алгоритмы ИИ для автоматического анализа сетевых угроз. Основным её преимуществом является способность адаптироваться к новым угрозам, обучаясь на реальных данных. Это делает её особенно полезной для крупных организаций с высокими требованиями к защите.

Система Darktrace, основанная на принципах машинного обучения, представляет собой ещё один пример эффективного использования ИИ. Её уникальная концепция «цифровой иммунной системы» позволяет обнаруживать аномалии в поведении пользователей и устройств. Такие решения демонстрируют высокий уровень адаптации, однако сложность настройки и высокая стоимость могут ограничивать их применение в небольших компаниях.

Основной вызов применения ИИ — это атаки Adversarial AI, которые обманывают системы безопасности, манипулируя данными [3]. Эти атаки подчеркивают необходимость разработки новых методов защиты и обучения моделей на устойчивых данных. Например, злоумышленники создают поддельные данные для обучения моделей, что снижает их точность и надёжность. Также важно учитывать этические аспекты и конфиденциальность данных, используемых для обучения ИИ.

Важной составляющей является разработка методик тестирования алгоритмов ИИ для повышения их устойчивости к целенаправленным атакам. Например, такие компании, как Google и Microsoft, внедряют собственные фреймворки для анализа устойчивости моделей, такие как TensorFlow Privacy и Microsoft SEAL. Эти инструменты помогают минимизировать риски использования уязвимостей в алгоритмах. В академической среде также ведётся активное исследование, направленное на разработку протоколов для тестирования Adversarial AI.

Существует также проблема ложных срабатываний, которые могут привести к сбоям в работе систем. Например, ошибки классификации сетевого трафика способны блокировать легитимных пользователей, что снижает эффективность защитных решений. В этом контексте особое внимание следует уделять развитию систем с высокой точностью и адаптивностью.

Наконец, необходимо учитывать, что использование ИИ требует значительных вычислительных ресурсов. Это делает технологии недоступными для некоторых организаций, особенно в условиях ограниченного финансирования. Кроме того, рост числа уязвимостей, связанных с использованием ИИ, требует постоянного совершенствования нормативной базы [4].

Перспективы развития ИИ в информационной безопасности становятся ключевым направлением для исследователей и практиков. Внедрение новых подходов, таких как интеграция технологий квантовых вычислений и ИИ, может обеспечить сверхзащищённые системы для обработки данных. Важным аспектом является использование методов коллективного машинного обучения, позволяющих организациям обмениваться опытом и данными для улучшения алгоритмов, не нарушая при этом конфиденциальность информации. Кроме того, системы прогнозирования угроз на основе анализа больших данных становятся всё более востребованными, позволяя предугадывать векторы атак и заранее подготавливать защитные меры.

Особого внимания заслуживают социальные и этические аспекты применения ИИ в информационной безопасности. Баланс между обеспечением безопасности и сохранением конфиденциальности данных остаётся важной задачей. Например, использование ИИ для автоматического принятия решений может вызывать вопросы относительно прозрачности алгоритмов и ответственности за возможные ошибки. Этика применения ИИ становится ключевым фактором, особенно в случаях, когда системы обрабатывают персональные данные или принимают решения в критических ситуациях [5]. Для решения этих проблем необходимы новые регуляции и стандарты, обеспечивающие справедливость и надёжность работы ИИ.

Согласно проведённому опросу специалистов в области кибербезопасности, более 70 % респондентов считают, что ИИ играет решающую роль в противодействии современным угрозам. Среди преимуществ ИИ выделяют автоматизацию рутинных процессов, повышение точности анализа данных и возможность оперативного реагирования на инциденты. Однако были отмечены и проблемы: высокие затраты на внедрение технологий, сложность настройки и необходимость защиты систем от манипуляций со стороны злоумышленников [6].

ИИ открывает большие возможности для автоматизации защиты данных, выявления угроз и управления инцидентами. Однако необходимы дальнейшие исследования для повышения устойчивости систем и минимизации рисков. Важным направлением является международное сотрудничество, стандартизация методов и усиление правовой базы для применения ИИ.

Проведённый анализ показывает, что внедрение ИИ позволяет:

— Сократить время реакции на инциденты.

— Автоматизировать рутинные процессы обработки данных.

— Выявлять угрозы, недоступные традиционным методам анализа.

Будущие исследования должны быть направлены на развитие прозрачных и безопасных алгоритмов, устойчивых к современным вызовам. Разработка устойчивых решений, способных противостоять атакам Adversarial AI, станет ключевым шагом на пути к созданию надёжной информационной среды.

По данным последних исследований, за последние пять лет количество кибератак, связанных с использованием ИИ, увеличилось более чем на 50 %. Это обусловлено ростом доступности технологий машинного обучения и их применением злоумышленниками. Например, автоматизация фишинговых атак и создание вредоносного программного обеспечения с использованием ИИ стали одними из самых распространённых угроз.

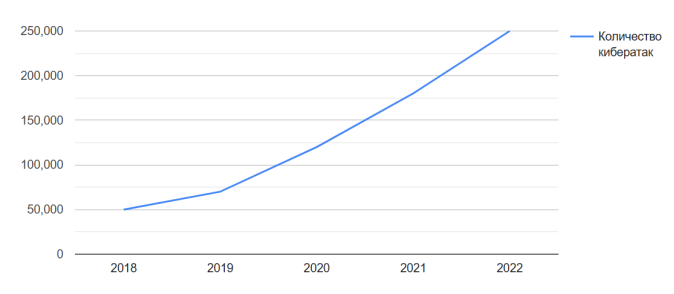

Для иллюстрации роста количества кибератак с использованием ИИ представлен график на рисунке 1, показывающий динамику угроз за последние пять лет. Данные свидетельствуют о значительном увеличении числа атак, что подчёркивает необходимость разработки адаптивных методов защиты [6].

Для повышения устойчивости систем к новым угрозам необходимо разрабатывать адаптивные модели безопасности. Эти модели должны использовать методы глубокого обучения для анализа сетевого трафика, предсказания атак и автоматизации реагирования на инциденты. Кроме того, важным аспектом является разработка алгоритмов, способных противостоять атакам Adversarial AI. Примером таких решений может быть интеграция методов анализа больших данных и технологий ИИ в существующие системы киберзащиты.

Рис. 1. Рост количества кибератак с 2018 по 2022

Для минимизации рисков, следует придерживаться следующих рекомендаций:

— Разработка устойчивых алгоритмов: необходимо внедрять подходы, которые позволяют моделям эффективно противостоять атакам Adversarial AI;

— Повышение прозрачности ИИ: создание систем с объяснимыми алгоритмами, которые позволят лучше понимать решения ИИ;

— Усиление нормативной базы: разработка законодательных инициатив, регулирующих использование ИИ в информационной безопасности;

— Международное сотрудничество: создание единого стандарта противодействия угрозам, связанным с ИИ, для обеспечения глобальной информационной безопасности.

Среди перспективных направлений исследований можно выделить создание гетерогенных сетей, где используются как централизованные, так и децентрализованные алгоритмы для защиты данных [7]. Это позволяет значительно повысить надёжность систем, особенно в условиях глобальных атак. Также значительный потенциал представляют технологии блокчейн для защиты данных, что в сочетании с ИИ обеспечивает прозрачность процессов обработки информации.

Искусственный интеллект открывает большие возможности для автоматизации процессов информационной безопасности, но одновременно порождает новые риски. Будущее развитие данной области должно быть направлено на повышение устойчивости систем, разработку международных стандартов и совершенствование алгоритмов. Только комплексный подход позволит использовать потенциал ИИ для создания надёжной цифровой среды.

Заключение

Современные технологии искусственного интеллекта представляют собой одновременно мощный инструмент для обеспечения информационной безопасности и угрозу, порождённую их использованием злоумышленниками. Проанализировав существующие методы и решения, можно сделать вывод о необходимости разработки устойчивых и адаптивных алгоритмов, которые смогут противостоять современным вызовам, таким как атаки Adversarial AI.

Для повышения эффективности ИИ необходимо усилить международное сотрудничество и стандартизацию, что позволит гармонизировать подходы к киберзащите на глобальном уровне. Особое внимание следует уделять вопросам этики и прозрачности алгоритмов, обеспечивая их использование в рамках законодательства и моральных норм.

Рассмотренные в статье примеры успешного применения ИИ, такие как системы Darktrace и IBM QRadar Advisor, подчёркивают огромный потенциал технологии в обнаружении и предотвращении кибератак. Однако остаются нерешённые проблемы, включая значительные затраты на внедрение, необходимость постоянного совершенствования алгоритмов и устранение ложных срабатываний.

Будущее информационной безопасности тесно связано с развитием искусственного интеллекта. Его интеграция в существующие системы требует комплексного подхода, объединяющего инновационные разработки, правовую поддержку и повышение уровня подготовки специалистов. Только такой симбиоз обеспечит создание безопасной цифровой среды, способной эффективно противостоять угрозам нового поколения.

Литература:

- Ахматова С. У. Этика и безопасность данных в эпоху искусственного интеллекта. // Вопросы информационной этики. — 2022. — № 3. — С. 89–95.

- Иванов И. И. Применение искусственного интеллекта для анализа сетевого трафика. // Вестник компьютерных наук. — 2022. — № 5. — С. 42–47.

- Ким Д. С. Адаптивные системы ИИ для защиты данных. —2023. — № 2. — С. 52–57.

- Савченко А. Р. Искусственный интеллект в анализе угроз и защите от кибератак. // Эпоха науки. — 2021. — № 4. — С. 65–72.

- Сидоров С. С., Петрова О. А. Методы защиты данных в условиях цифровой эпохи. // Кибербезопасность. — 2021. — № 2. — С. 18–23.

- Хакимов А. А. Роль искусственного интеллекта в кибербезопасности. // Вестник науки. — 2023. — № 5. — С. 42–48.

- Хакимов А. А. Искусственный интеллект в кибербезопасности: угрозы, возможности и этические размышления. // Вестник науки. — 2023. — № 2. — С. 76–82.