Поскольку искусственный интеллект (ИИ) становится все более способным решать очень сложные задачи, многим продуктам и услугам с поддержкой ИИ предоставляется более высокая автономия принятия решений, потенциально оказывая разнообразное влияние на людей и общества. Хотя организации и исследователи неоднократно демонстрировали благословения ИИ для человечества, серьезные злоупотребления и инциденты, связанные с ИИ, вызвали насущные этические проблемы. На этом фоне цели этой статьи — предоставить отправную точку для исследований этических проблем, связанных с ИИ, и осветить будущие исследовательские возможности.

Ключевые слова: искусственный интеллект, ИИ, машины, алгоритмы, этика, этическое использование.

Искусственный интеллект (ИИ), то есть «способность машины выполнять когнитивные функции, которые мы связываем с человеческим разумом, такие как восприятие, рассуждение, обучение, взаимодействие с окружающей средой, решение проблем, принятие решений и даже демонстрация реактивности» [1], является уникальной технологией по многим причинам. Людям не только сложно понимать и проверять решения ИИ, но также сложно установить правила его использования, поскольку ИИ постоянно развивается.

Этот «черный ящик» в применении алгоритмов ИИ приводит к отсутствию прозрачности даже среди создателей и создает особые этические проблемы. Как часть обществ, бизнес-организации сталкиваются с проблемами, касающимися возможностей и последствий экономики, все больше основанной на ИИ [2–4]. Неясно, например, что происходит, когда системы на основе ИИ объединяются и когда они производят результаты, которые невозможно оценить заранее.

С одной стороны, растущее влияние ИИ на людей и их общества сопровождается растущим давлением на организации, чтобы они брали на себя ответственность за свои продукты и предложения ИИ, включая этические соображения, связанные с потенциальными последствиями использования ИИ на социальном, экологическом и экономическом уровнях. С другой стороны, это сопровождается заметным сдвигом в рабочей силе: все большая опора на ИИ, вероятно, заменит некоторые рутинные рабочие места, связанные с задачами, чтобы фирмы оставались конкурентоспособными по сравнению с другими, переходящими на автоматизированные практики.

Этические соображения ИИ должны быть воплощены в принятии управленческих решений в первую очередь, начиная с информирования повседневных операций. Все больше и больше организаций хотят взять на себя эту ответственность [5], но не у каждого сотрудника есть время и ресурсы, чтобы целостно рассмотреть и осмыслить в настоящее время фрагментированный научный дискурс. Эта фрагментация создает риск для социального, экологического и экономического устойчивого использования ИИ. Дискуссия об организационной этике ИИ все еще находится в начальном состоянии, и текущие исследования этики ИИ находятся в нескольких областях, включая, помимо прочего, философию, компьютерные науки, информационные системы (ИС) и управленческие исследования. Для этой статьи мы формулируем следующие два исследовательских вопроса:

Вопрос 1: Каково текущее положение дел в отношении исследований по управлению этическими аспектами ИИ?

Вопрос 2: Каковы потенциальные пробелы и направления будущих исследований по этой теме?

Чтобы ответить на эти вопросы, мы провели поиск и обзор литературы, которые привели нас к выводу, что в настоящее время мало исследований по этой теме. На этом фоне наша цель — предоставить начальную структуру того, как концептуализировать управление этикой ИИ, что, как мы надеемся, приведет к будущим исследованиям по этой теме. Мы представляем структуру того, как связать воедино три перспективы: (1) принятие управленческих решений, (2) этические соображения и (3) различные макро- и микросредовые измерения, с которыми взаимодействует организация. Применение этой структуры для руководства принятием решений является неотъемлемой частью этической ответственности организации. Подводя итог, мы предлагаем прагматическое мнение о концептуализации этичного управления ИИ в организациях.

Организации должны быть способны решать этические вопросы, касающиеся ИИ, не в последнюю очередь для того, чтобы избегать неэтичных, а также потенциально вредных последствий своих технологий на основе ИИ [6]. Хотя организации являются частью гонки вооружений ИИ, они должны взять на себя ответственность за рассмотрение этических аспектов ИИ. Этого могут требовать не только политики и законы, но и неучтенные последствия могут серьезно повлиять на всю организацию, например, через судебные иски или негативное внимание СМИ. Менеджеры знают или могут легко знать о потенциальных последствиях, которые могут иметь их решения. Таким образом, неэтичное поведение редко случается просто «случайно». Однако в контексте ИИ такое неэтичное поведение может происходить не только «по замыслу», но и как непреднамеренное следствие и, таким образом, просто по «случайности» или «внешним причинам». Например, чат-бот тay, выпущенный Microsoft в 2016 году, стал расистским после того, как был обучен пользователями в Twitter, но не был предназначен или спроектирован как оскорбительный [7]. Для организаций это поднимает вопрос о том, какие этические принципы следует использовать для разработки и управления технологиями на основе ИИ. В исследованиях одним из аспектов, который привлекает все больше внимания, является прогнозирование индустрии 5.0 [6]. В отличие от индустрии 4.0, где основное внимание уделяется автоматизации, индустрия 5.0 касается синергии людей и роботов. По сути, роботы и люди являются соавторами, а не конкурентами. Следовательно, можно ожидать, что фокус отраслей сместится с технического развития систем на социальные потребности людей. Однако отсутствуют руководящие принципы и рамки того, как сделать ИИ управляемым.

Что касается этического управления ИИ, если ИИ можно (по крайней мере на данный момент) классифицировать на основе скорости самообучения, возникает вопрос о том, как мы можем структурно рассматривать этические аспекты ИИ в организациях. Этика определяется как часть философии, которая занимается предпосылками и оценкой человеческих действий и является методическим размышлением о морали [2].

В центре этики находится конкретное моральное действие, особенно его оправданность и размышление. Мы предполагаем, что этические соображения имеют большую значимость, если технология, поддерживающая ИИ, находится в более тесном взаимодействии с людьми. Инструменты ИИ, такие как рекомендации, прогнозирование или алгоритмы оптимизации, которые повышают эффективность анализа больших наборов данных, сами по себе не являются высокоприоритетными для этического рассмотрения, поскольку их прямое влияние на человеческие жизни можно считать низким.

Кроме того, ИИ может напрямую взаимодействовать с пользователями в таких случаях, как чат-боты в обслуживании клиентов, или влиять на жизнь отдельных лиц или групп меньшинств, ставя в невыгодное положение кандидатов на собеседованиях в отделе кадров или управляя беспилотными автомобилями [3]. Основываясь на этих двух предположениях, мы разделяем ИИ в организациях по следующим двум измерениям:

- Степень и скорость самообучения;

- Степень воздействия ИИ на людей.

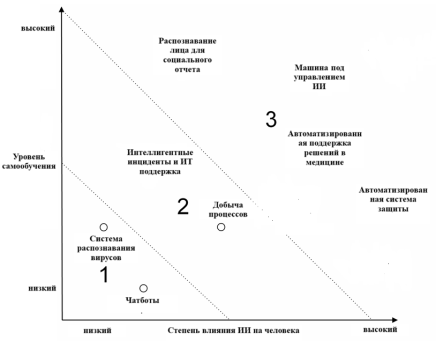

Мы выбрали и классифицировали случаи (рис. 1) в качестве примера, чтобы описать диапазон текущих технологий на основе ИИ, и не претендуем на полноту и не основываемся на конкретных числах. Наша позиционирование ИИ напоминает подход матрицы портфеля, поскольку он распространен в деловом администрировании и широко применяется на практике, например, Boston Consulting Group и McKinsey, в котором охватываемые измерения делятся на три сектора. Первый сектор охватывает технологии на основе ИИ, которые, по нашему мнению, имеют низкую степень самообучения и низкую степень воздействия на людей.

Рис. 1. Позиционирование (классификация) матрицы случаев

Из-за как более низкого уровня близости человека и ИИ, так и самообучения, вероятность возникновения ошибок, вызванных ИИ, также ниже. Соответственно, мы не классифицируем этот сектор как особенно релевантный для этического управления ИИ.

Второй сектор касается всех случаев как среднего уровня самообучения, так и воздействия на людей. Этот сектор более актуален для этического управления ИИ, поскольку эти технологии могут оказывать более существенное влияние на жизнь и поведение людей.

Третий сектор охватывает технологии ИИ, которые оказывают большое влияние на жизнь людей и которые мы классифицируем как обладающие высокой степенью самообучения. Одним из примеров может быть интеллектуальная система поддержки принятия решений в электронном здравоохранении, которая может помочь медицинскому персоналу принимать решения относительно состояния здоровья людей и рекомендовать методы лечения.

С философской точки зрения этика социального выбора также затрагивает вопрос о том, как можно разработать технологию ИИ, чтобы она могла принимать моральные решения. Баум [7] выделил три решения, основанные на нормативной этике, которые необходимо принять в этом отношении: (1) положение (относительно того, чьи взгляды на этику включены), (2) измерение (относительно того, как определяются их взгляды) и (3) агрегация (относительно того, как личные взгляды объединяются в единый взгляд, который может направлять поведение ИИ). Эти решения в любом случае должны быть приняты до разработки ИИ и не должны быть оставлены на усмотрение самообучающегося ИИ. Другой автор задался вопросом, какие риски возникают, когда мы создаем ИИ по нашему образу и подобию [7].

В экономическом измерении организации должны целостно рассматривать влияние своего ИИ на экономическую систему. Здесь «экономическая система» относится к рыночной, национальной и глобальной экономике. Накапливая переговорную силу или значительные доли рынка, организации могут оказывать все большее влияние на экономическую систему. Подобная экономическая мощь может возникнуть из-за таких разработок, как роботы-консультанты, автономно инвестирующие и торгующие Поскольку ИИ проникает практически во все аспекты нашей жизни, эта статья иллюстрирует, что ИИ затрагивает соответствующие этические вопросы, влияя на наше общество на социальном, экологическом и экономическом уровнях [3].

В этой статье рассматривается проблема фрагментированного дискурса об этическом управлении ИИ. Как и в случае с большинством этических дискурсов, организационная или деловая этика не может рассматриваться как черно-белая, или правильная, и неправильная [4]. Хотя некоторые основные положения широко согласованы (например, Всеобщая декларация прав человека, Организации объединенных наций), этические соображения несут на себе сильный культурный отпечаток. Тем не менее, это не должно мешать ученым подчеркивать важность этических соображений.

Литература:

- Rai A., Constantinides P., Sarker S. Editor’s Comments: Next-Generation Digital Platforms: Toward Human-AI Hybrids. Manag. Inf. Syst. Q. 2019, 43, III-IX.

- Frey C. B., Osborne M. A. The Future of Employment: How Susceptible Are Jobs to Computerisation? Technol. Forecast. Soc. Chang. 2017, 114, 254–280. [CrossRef]

- Munoko I., Brown-Liburd H. L., Vasarhelyi M. The Ethical Implications of Using Artificial Intelligence in Auditing. J. Bus. Ethics 2020, 167, 209–234. [CrossRef]

- Russell S. J., Norvig P. Artificial Intelligence: A Modern Approach; Pearson Education Limited: London, UK, 2016.

- Kolbjørnsrud V., Amico R., Thomas R. J. The Promise of Artificial Intelligence; Accenture: Dublin, Ireland, 2016.

- Payne D., Raiborn C., Askvik J. A Global Code of Business Ethics. J. Bus. Ethics 1997, 16, 1727–1735.

- Nahavandi S. Industry 5.0 — A Human-Centric Solution. Sustainability 2019, 11, 4371.